Google BERT Update – Die Kontext-Revolution

In diesem Artikel erfährst du, wie das Google BERT Update, die Suchmaschine auf ein völlig neues Level brachte – und wieso BERT auch heute noch für SEO relevant ist.

Ich zeige dir:

✅ Was sich genau durch BERT geändert hat

✅ Wie BERT genau funktioniert

✅ Welchen Content BERT liebt

Inhalt

Was ist das Google BERT Update?

Das Google Update BERT (2019) steht für „Bidirectional Encoder Representations from Transformers“ und markierte einen echten Wendepunkt in der Entwicklung der Google-Suche.

Seit BERT versteht Google Texte ähnlich, wie Menschen Texte verstehen: Im Kontext!

Das revolutionäre an BERT: Google kann seitdem erkennen, wie die Wörter zueinanderstehen und gemeinsam Sinn ergeben. Besonders bei Longtail Keywords, komplexen Suchanfragen oder ungewöhnlicher Satzstellung sorgt BERT dafür, dass Google die Nutzerintention viel genauer erfassen kann.

„Bidirectional Encoder Representations from Transformers“. Klingt erstmal ganz schön technisch, ist aber eigentlich schnell erklärt:

Bidirectional bedeutet: Das Modell liest einen Text in beide Richtungen – also von links nach rechts und von rechts nach links. So kann BERT den vollständigen Zusammenhang eines Wortes erfassen. Das ist viel genauer als ältere Modelle, die nur in eine Richtung schauen.

Encoder Representations meint: BERT erzeugt eine Art digitale Zusammenfassung (Embeddings) für jedes Wort – und zwar abhängig vom Kontext. Das Wort „Bank“ wird zum Beispiel unterschiedlich verstanden, je nachdem ob es sich zum Beispiel wörter wie Geld oder Sitzen im Text befinden.

from Transformers bezieht sich auf das Transformer-Modell, das die Grundlage für BERT bildet. Der Transformer ist eine moderne Architektur für KI, die besonders gut darin ist, Zusammenhänge in Texten zu erkennen – viel besser als ältere Ansätze.

Kurz gesagt: Der Name beschreibt genau das, was BERT macht:

Ein Modell, das mithilfe von Transformern Text in beide Richtungen liest und dadurch besonders gut im Wort-Verständnis ist.

Das Ergebnis: Suchanfragen, in denen kleine Wörter wie „nach“, „zu“, „auf“ oder „für“ den Sinn verändern, werden von Google seit BERT deutlich besser verstanden.

Beispiel

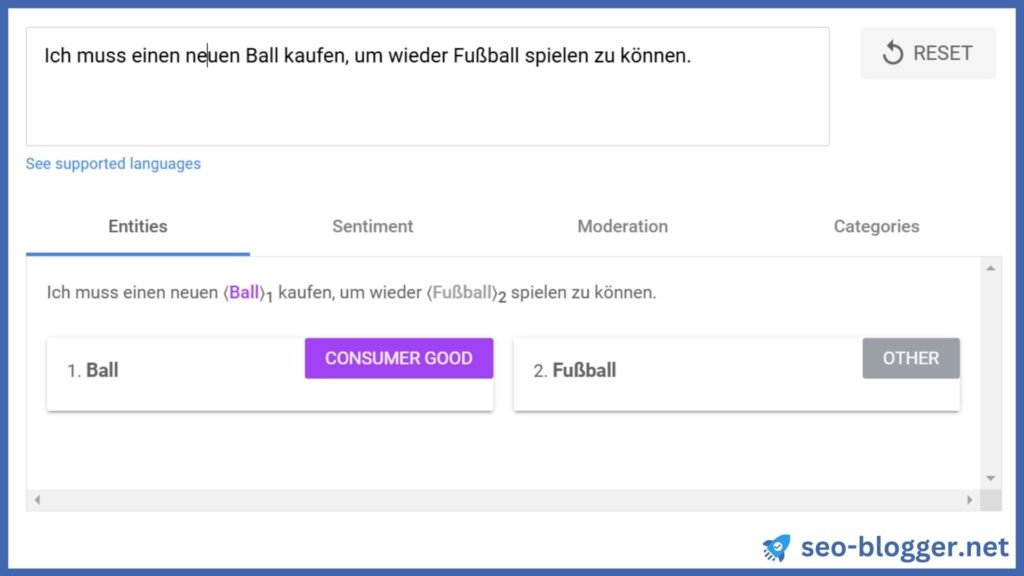

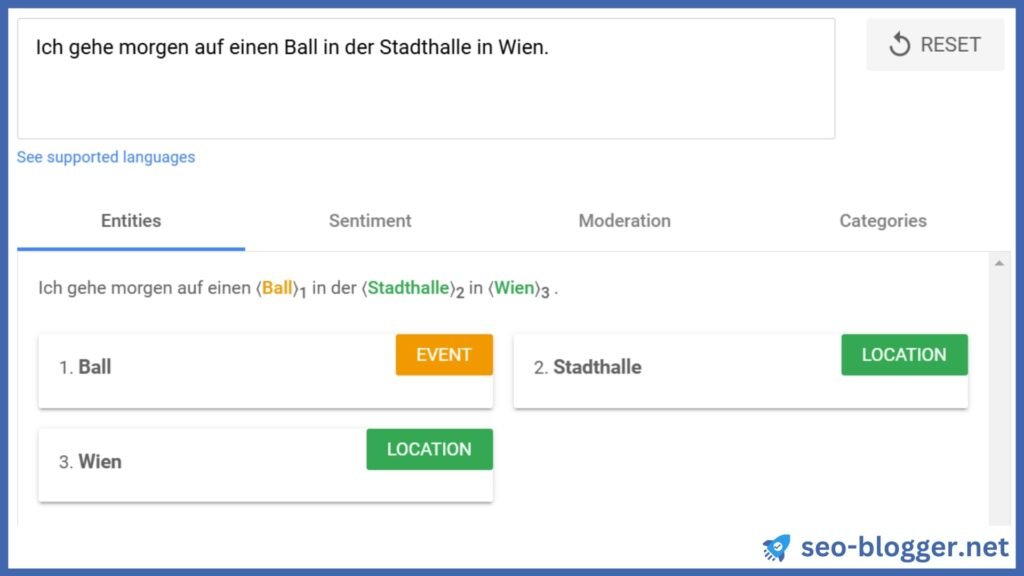

Hier habe ich die Google Natural Language API verwendet, um Entitäten (ein fancy Wort für Dinge) in einem Text von mir erkennen zu lassen:

Durch neuronales Lernen an unzähligen Texten weiß Google dank BERT, dass das Wort Ball in diesem Kontext einen kaufbaren Ball beschreibt.

In diesem Fall, versteht Google, dass es sich um das Event und nicht um einen Ball zum Spielen handelt.

Wie wurde BERT entwickelt?

BERT wurde nicht einfach mit klassischen Fragen-Antworten trainiert, sondern bekam eine große Anzahl an „Rätseln“:

Masked Language Model (MLM): Einige Wörter in einem Satz werden absichtlich versteckt. BERT muss erraten, welche das sind – und zwar nur anhand des Kontexts.

Next Sentence Prediction (NSP): Das Modell soll erkennen, ob zwei Sätze logisch zusammengehören.

Warum ist das wichtig? Durch diese Aufgaben entwickelt BERT ein richtig gutes Sprachverständnis – und das merkt man bei modernen Google-Suchen sofort. Die Suchmaschine kann dadurch viel besser herausfinden, was Nutzer wirklich wissen wollen.

Historische Einordnung

Die Updates Humminbird und and RankBrain können als die Wegbereiter von von BERT betrachtet werden:

1. Hummingbird (2013)

Das Hummingbird-Update war ein echter Meilenstein:

Google begann damit, nicht mehr nur einzelne Keywords in einer Suchanfrage zu berücksichtigen, sondern versuchte, ganze Sätze und die Bedeutung dahinter zu verstehen. Das war der erste Schritt weg von der klassischen „Keyword-Suche“ hin zur sogenannten semantischen Suche.

2. RankBrain (2015)

Mit RankBrain führte Google erstmals künstliche Intelligenz (Machine Learning) in den Suchalgorithmus ein. RankBrain half dabei, besonders neue oder noch nie dagewesene Suchanfragen besser zu interpretieren und den Nutzer-Intent zu verstehen. RankBrain „lernte“, wie Menschen suchen und was sie meinen – ein riesiger Fortschritt für das Suchverständnis.

3. BERT (2019)

Durch die „bidirektionale“ Verarbeitung kann Google jetzt auch Bedeutungsnuancen, Präpositionen und mehrdeutige Begriffe viel besser erkennen und passende Suchergebnisse liefern.

BERT wird übrigens auch heute noch von Google eingesetzt – Bei komplexeren Aufgaben werden heute jedoch immer häufiger spezialisierte Modelle von Gemini eingesetzt, um zum Beispiel AI Overviews zu generieren.

Auswirkung von BERT auf die SEO

1) Verbessertes Suchverständnis und Kontextanalyse

Missverständnisse, wie sie früher bei mehrdeutigen Suchbegriffen vorkamen, passieren deutlich seltener. Google erkennt wesentlich besser, „was wirklich gemeint“ ist, statt einfach stur das Hauptkeyword zu finden. Gerade für Nischenthemen, komplexe Fragen oder spezifische Zielgruppenanfragen hat sich die Sichtbarkeit verbessert.

2) Veränderungen von Rankingfaktoren

BERT hat dafür gesorgt, dass die reine Platzierung von einzelnen Keywords viel weniger Bedeutung hat. Google bewertet jetzt wesentlich feiner, ob eine Seite wirklich die Nutzerintention trifft und Zusammenhänge im Text logisch auflöst.

Was das konkret heißt:

- Natürliche Texte, klar strukturierte Informationen und echte Antworten auf die User-Frage kriegen Vorfahrt.

- Seiten, die nur auf klassische Ranking-Faktoren wie Keyworddichte setzen, wurden seit BERT gnadenlos abgestraft.

3) On-Page Optimierung im Zeitalter von BERT

Kurz gesagt: Textqualität schlägt Technik.

Natürlich blieben die SEO-Basics (zum Beispiel Focus Keyword in Title Tag, H1, Content und URL) nach BERT weiterhin bestehen. Jedoch funktionierten diese Techniken langfristig nicht mehr ohne echten Mehrwert im Content.

Das A&O bei On-Page:

✅ Nutze verständliche, korrekte Sprache und beantworte Fragen möglichst direkt

✅ Setze auf FAQs, sinnvolle Zwischenüberschriften, erklärende Absätze

✅ Verwende natürliche Synonyme und semantisch verwandte Begriffe

Noch ein Hinweis: Bei der Texterstellung hilft dir ein Tool wie Page Optimizer Pro, um Themenfelder vollständig abzudecken und relevante Begriffe zu finden, die du INHALTLICH in deine Texte einbauen solltest. Dies kann häufig genau den Kontext liefern, den BERT „sehen“ möchte.

4) Bedeutung der Suchintention

Die wichtigste Erkenntnis aus dem BERT-Update: Google rankt seitdem Seiten, die möglichst exakt das Problem oder das Anliegen des Nutzers lösen.

Was richtig gut funktioniert:

✅ Prägnante Sprache (enthält mehr Kontext bei gleicher Textlänge)

✅ Strukturierte Antworten und detailierte Anleitungen

✅ Klarheit WER für WEN schreibt

✅ Erweiterte Inhalte wie FAQs, die zusätzlichen Kontext liefern

Du merkst: SEO ist mit BERT ganz klar Content-getrieben – jeder Text, der den User und sein Anliegen in den Mittelpunkt stellt, gewinnt.

👉 In diesem Artikel zeige ich dir, wie du die Suchintention deiner Zielgruppe genau triffst.

SEO Best Practices

Die wichtige Konsequenz von BERT für SEO ist die Folgende:

Je besser du Sprache im Kontext nutzt, desto besser kann Google die tatsächliche Relevanz deiner Inhalte erkennen.

Daraus ergeben sich die folgenden Best Practices:

Content mit Tiefe

Google BERT sorgt dafür, dass Suchanfragen deutlich besser verstanden werden – und zwar im Kontext, nicht mehr rein auf Keyword-Ebene. Thematischer Tiefgang und umfassende Antworten auf Nutzerfragen gewannen seitdem massiv an Bedeutung.

Die wichtigsten Stellschrauben für Marketer sind daher, Fragestellungen aus echten Nutzeranfragen im Inhalt in der Breite und Tiefe zu beantworten.

Optimiere Inhalte nicht isoliert, sondern in einem Themenclustern rund um ein zentrales Thema!

👉 In diesem Ratgeber zeige ich dir, wie du thematische Autorität rund um ein Thema aufbaust.

Content-Optimierung mit Fokus auf Nutzerintention

Verstehe die Fragen deiner Zielgruppe!

So triffst du ins Schwarze:

- Starte die Keyword-Recherche wie bisher, gehe dann aber einen Schritt weiter.

- Recherchiere in Foren, Reddit oder Kommentaren, WIE Nutzer tatsächlich fragen.

- Wandle Hauptkeywords in echte Fragen um („Ist es arbeitsrechtlich zulässig, dass mein Arbeitgeber mich für 4 Jahre verpflichtet?“).

- Baue sämtliche relevanten Longtail-Varianten und Nutzerfragen sinnvoll in deinen Content ein.

- Schreibe zu jedem Unterthema einen eigenen Abschnitt – am besten mit Listen, Anleitungen oder Step-by-Step Tipps.

So erkennt BERT sofort, dass du echte Probleme umfassend löst.

Häufige Fehler

❌ Suchanfragen immer noch wie klassische Keywords behandeln

❌ Keyword-Stuffing statt Kontext und Relevanz

❌ Wichtige semantische Begriffe und Synonyme ignorieren

❌ Blindes Kopieren aus Keyword-Tools – zu wenig Nutzerfokus

❌ Keyword Kannibalisierung durch zu ähnliche Inhalte auf mehreren Seiten

❌ Kurze, nichtssagende Antworten ohne tiefere Erklärung

❌ Fehlende Synonyme, die in natürlicher Sprache vorkommen

❌ Keine Auseinandersetzung mit echten Fragen der Zielgruppe

Praxisbeispiele

Negativbeispiel

Ein Anwalt für Arbeitsrecht will auf seiner Website Blogartikel erstellen lassen, um seine Sichtbarkeit zu erhöhen. Eine SEO-Agentur bietet ihm an für die meistgesuchten Keywords Artikel zu schreiben.

„Anwalt für Arbeitsrecht“,

„Rechtsschutzversicherung Arbeitsrecht“,

„Abmahnung Arbeitsrecht“,

usw.).

Das Resultat sind 20 generische Artikel zu arbeitsrechtlichen Themen, die zwar professionell wirken, aber viel zu generisch sind und dadurch keine hohen Rankings erzielen.

Positivbeispiel

Ein anderer Anwalt für Arbeitsrecht folgt diesem Leitfaden für die Zielgruppenrecherche mit Perplexity und erfährt dadurch sämtliche konkreten Fragen, die tatsächlich von Menschen auf Reddit und Quora zum Thema Arbeitsrecht gestellt werden:

-

„Kann mein Arbeitgeber mich verpflichten, regelmäßig Mehrarbeit zu leisten?“

-

„Wie sieht es aus, wenn ich einfach bei meinem Arbeitgeber nicht mehr auftauche, nachdem ich von meinem Chef beleidigt wurde?“

-

„Darf ich mich für vier Jahre an ein Unternehmen binden? Ist das rechtlich überhaupt zulässig?“

- etc.

Er ordnet diese Fragen nach Themen und beantwortet diese in mehreren Blogartikeln. Schon nach einigen Monaten rankt er für viele unterschiedliche Keywords zu Arbeitsrecht und erhält dadurch viele weitere Kunden.

BERT erkennt hier, obwohl sich möglicherweise in beiden Fällen die gleiche Anzahl an Keywords in den Texten befinden, anhand des Kontexts im Text, welcher Inhalt der relevantere ist.

Nils Peter Neumann

Ich bin Autor dieses Blogs und arbeite als SEO Experte für Unternehmen in Deutschland, Österreich und der Schweiz. Schreibe JETZT deine Nachricht in das Kommentarfeld, wenn du Fragen zu SEO hast.